Anotación automática de vídeo para vehículos sin conductor a prueba de riesgos

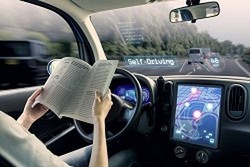

La carrera para lanzar al mercado el primer coche sin conductor del mundo ya ha comenzado. Ya tenemos una idea bastante precisa de cómo será su aspecto: un coche cubierto con todo tipo de cámaras y sensores que registrará y analizará todo lo que pase en su entorno, en tiempo real. Según los expertos, esto equivale a 10 terabytes de datos generados cada día solo para el vídeo. Se prevé que los futuros coches sin conductor incluirán una diez cámaras CMOS como parte de sus sistemas activos de conducción asistida (ADAS). La anotación de los datos generados para cuestiones como los objetos, los eventos y las escenas del tráfico rodado será esencial para probar y entrenar a los sistemas de visión artificial, sin los cuales el coche no sería capaz de tomar la decisión adecuada en el momento adecuado. Y ahí es donde está el vacío: actualmente faltan conjuntos de datos de vídeo etiquetados y realistas y con el tamaño, la complejidad y la exhaustividad suficientes para entrenar la visión artificial de los futuros coches sin conductor. «La generación o el etiquetado de metadatos es una labor tediosa. Normalmente se hace de forma manual dibujando cuadros o píxeles y etiquetándolos individualmente, fotograma a fotograma. Esta anotación humana es lenta, incoherente y demasiado costosa. Además, la ocasión de capturar este conocimiento humano mientras se anota y de transmitirlo al proceso de entrenamiento no se aprovecha al máximo», explica la doctora Oihana Otaegui, responsable de sistemas de transporte inteligentes e ingeniería en Vicomtech, un centro español de investigación especializado en visión artificial. Con una tecnología de análisis de vídeo apta para la nube y herramientas para combinar el vídeo con otras fuentes de datos, estos problemas podrían resolverse fácilmente. Precisamente para eso es el proyecto Cloud-LSVA (Cloud Large Scale Video Analysis): para crear grandes conjuntos de datos de entrenamiento que se usarán en sistemas de detección basados en la visión, junto con descripciones de escenas sobre el terreno basadas en objetos y eventos, con el fin de evaluar el rendimiento de los algoritmos y los sistemas configurados en el coche. «Nuestra plataforma de datos masivos puede anotar previamente grandes conjuntos de datos de vídeo y cargarlos en una infraestructura de nube. Allí, cada escena grabada será analizada y descompuesta para detectar y clasificar los objetos y eventos relevantes para escenarios concretos», explica la doctora Otaegui, quien también afirma lo siguiente: «En la segunda fase, la herramienta de anotación ayuda a los usuarios a refinar y aumentar las anotaciones. Finalmente, se aplican técnicas de aprendizaje en línea para actualizar los modelos de detección y clasificación, y para incluir conocimiento humano en los procesos automáticos. En algunos escenarios también se incluirán mecanismos de razonamiento que permitirán la anotación automática de conceptos complejos no entrenados anteriormente ni etiquetados por operadores humanos, lo que producirá descripciones automáticas de las escenas». A partir de ahí, los usuarios y las aplicaciones pueden realizar consultas semánticas en archivos de vídeo a través de metalenguajes, así como consultas por facetas que permitirán compartir rápidamente los resultados: el análisis en línea de vídeo de datos masivos a nuestro alcance. Aunque su objetivo principal son las funciones ADAS para vehículos automatizados y la generación cartográfica de alta definición, Cloud-LSVA también contempla el uso de catálogos de escenas a partir de iniciativas de análisis de accidentes (GIDAS – Estudio alemán de accidentes en profundidad) o la evaluación de la calidad del sistema dentro del vehículo (Euro NCAP – Programa europeo de evaluación de coches nuevos). Más allá del sector del automóvil, también se tienen en cuenta aplicaciones en los sectores de la robótica y la salud (que tiene una necesidad parecida de anotación de imágenes médicas). Planes para el futuro El proyecto se habrá completado a finales de 2018. Para entonces, el equipo todavía tendrá que completar el ciclo entre las capacidades de procesamiento dentro del vehículo y la computación en la nube, con el fin de facilitar un ciclo de procesamiento totalmente recurrente: la nube aprende de las anotaciones, actualiza los modelos y los envía a los vehículos para aumentar el rendimiento con el tiempo. Una vez pasado este plazo, la doctora Otaegui también prevé que «dentro de no mucho tiempo habrá flotas de coches de prueba y, posiblemente, algún día habrá coches particulares circulando y recopilando volúmenes de datos aún mayores, lo que después requerirá un incremento equivalente de las capacidades de computación en la nube y de comunicación de la plataforma para recibir y procesar los datos». Cloud-LSVA ya aborda este futuro problema adoptando una arquitectura informática en la que las capacidades de procesamiento están mejor conectadas con al origen de los datos, es decir, con el coche. «La participación de Valeo e IBM en el proyecto ha ofrecido la oportunidad de explorar los últimos avances en visión artificial integrada dentro del vehículo con el fin de anotar previamente todos los datos sobre la marcha mientras se está grabando», afirma la Dra. Otaegui.